1986年,Michael Lesk 設計出一個簡單的演算法,基本的概念為給定一個詞彙,其周圍的詞彙會傾向於在說明同一個主題,或者說它們分享著相似的概念[1],除了原始的paper外,還可以在wikipedia找到 Lesk 演算法的說明[2]。

接著,我實作了原始 paper 中的演算法[1],wikipedia上的版本[2]跟原始 paper 有著部份的出入,下方我會開始解釋實作的程式碼:

葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(293)

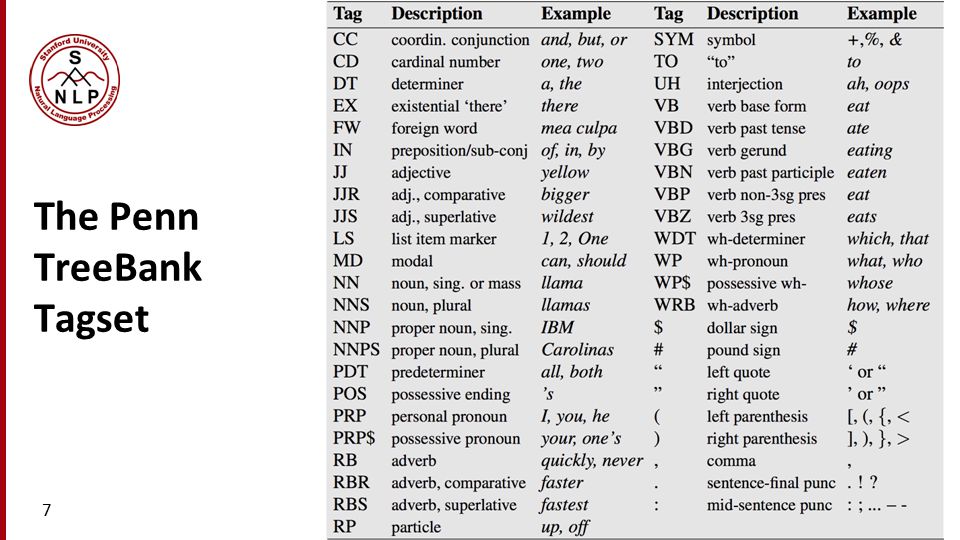

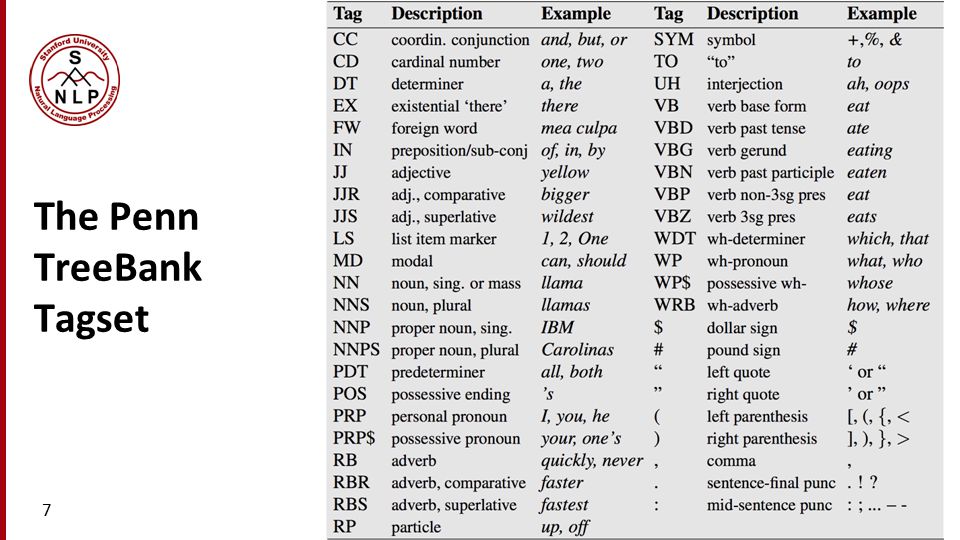

在此特別紀錄賓州大學的中英文詞性列表,以方便查詢,上圖是英文的詞性列表 (POS tagset),說明如下:

英文詞性列表 (POS tagset):

葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(325)

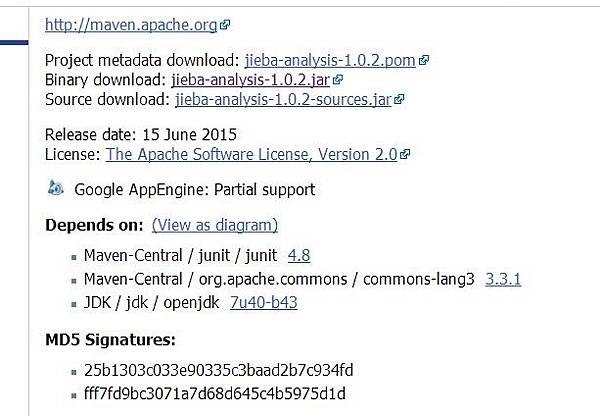

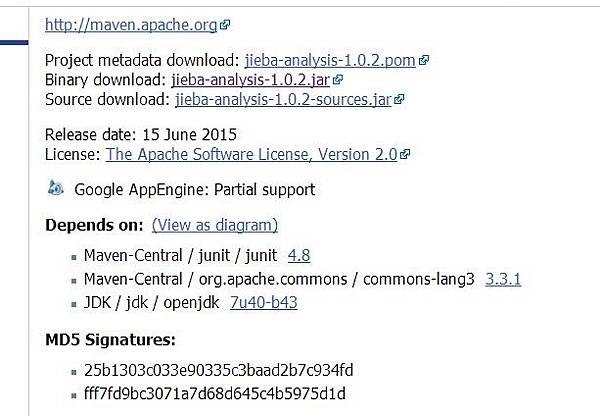

以下記錄在Python中使用結巴中文斷詞的方法:

葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(7,438)

Jieba

中文斷詞 葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(508)

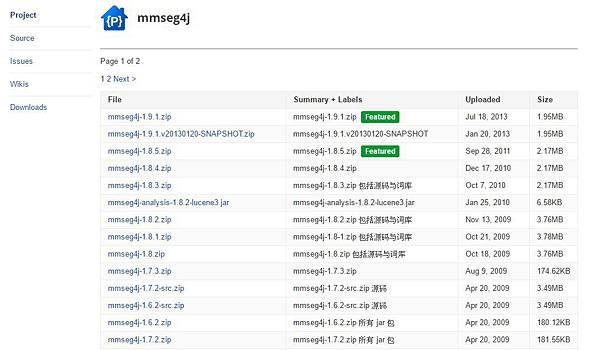

MMSeg

是由Chih-Hao Tsai

所開發,裡面包含了兩種類型的長詞優先斷詞演算法(Maximum Matching Algorithm)

。其官網如下:

葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(485)

介紹

介紹IK Analyzer

斷詞系統開發語言為Java

,是為了建立在Lucence

專案裡面的元件而發展的,最早期的版本出現在2006

年。此斷詞系統有不同的斷詞模式:

最小粒度斷詞與智能斷詞,其主演算法本身為辭典式斷詞。葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(256)

ConceptNet

是MIT(

美國麻省理工學院)

的一個計畫,它是一個語意網路,包含了各種事物之間的關聯性。葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(1,158)

葛瑞斯肯 發表在 痞客邦 留言(1) 人氣(823)

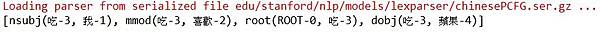

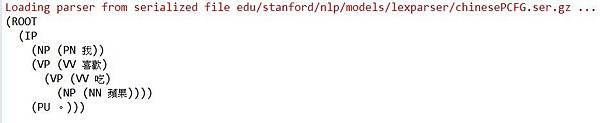

Stanford jar 檔的安裝方式請參閱:

http://xken831.pixnet.net/blog/post/448840217-%5BTextMining%5DStanford%20parser%20%E4%BD%BF%E7%94%A8%E6%96%B9%E5%BC%8F

葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(251)

Step 1:

請到下列的網址葛瑞斯肯 發表在 痞客邦 留言(0) 人氣(1,140)

Jieba

Jieba  MMSeg

MMSeg

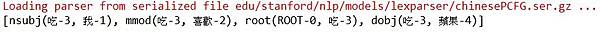

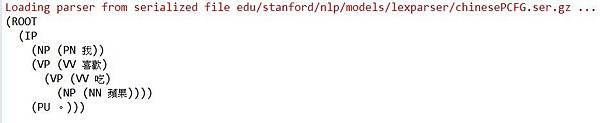

使用 Stanford 中文斷詞系統,首先,請到下列的網址:

使用 Stanford 中文斷詞系統,首先,請到下列的網址: